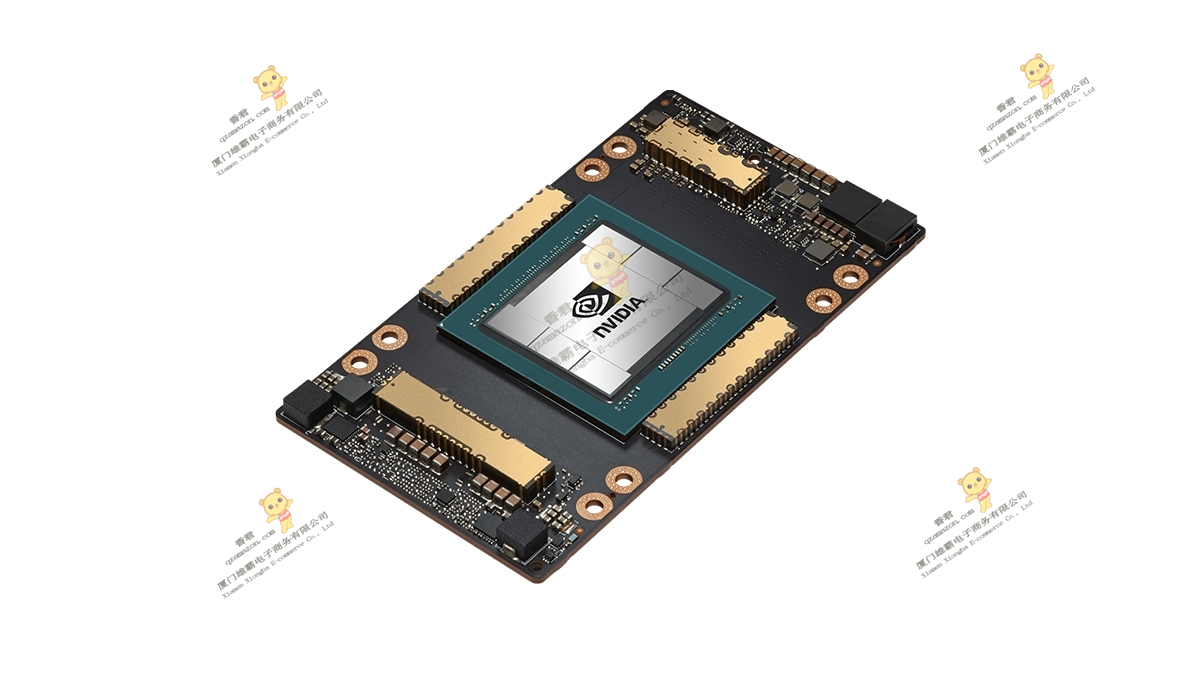

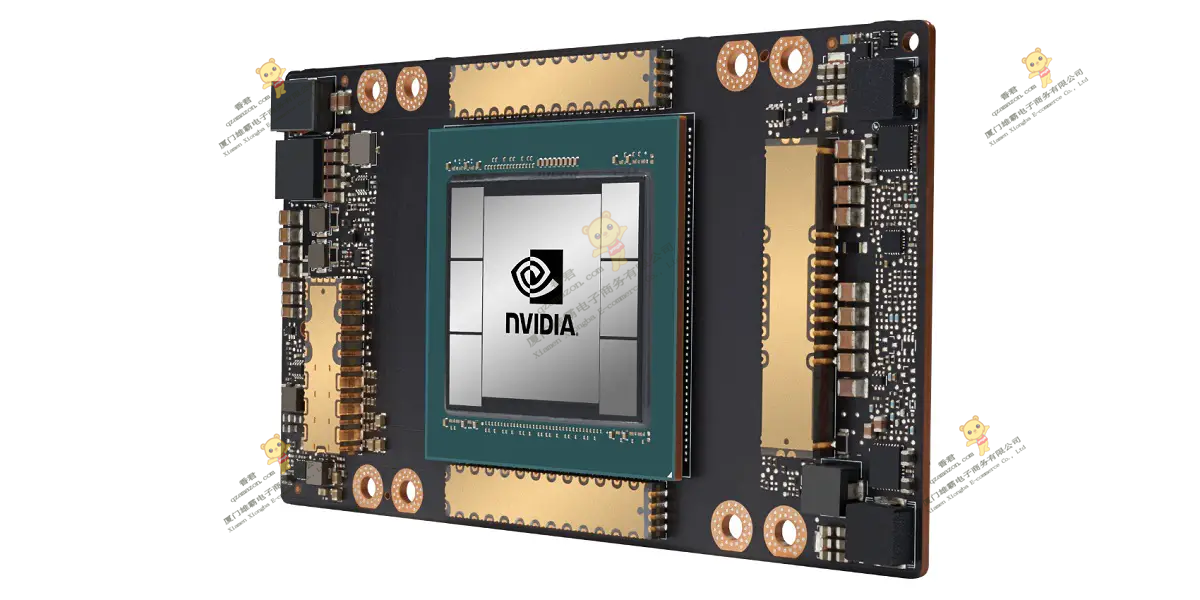

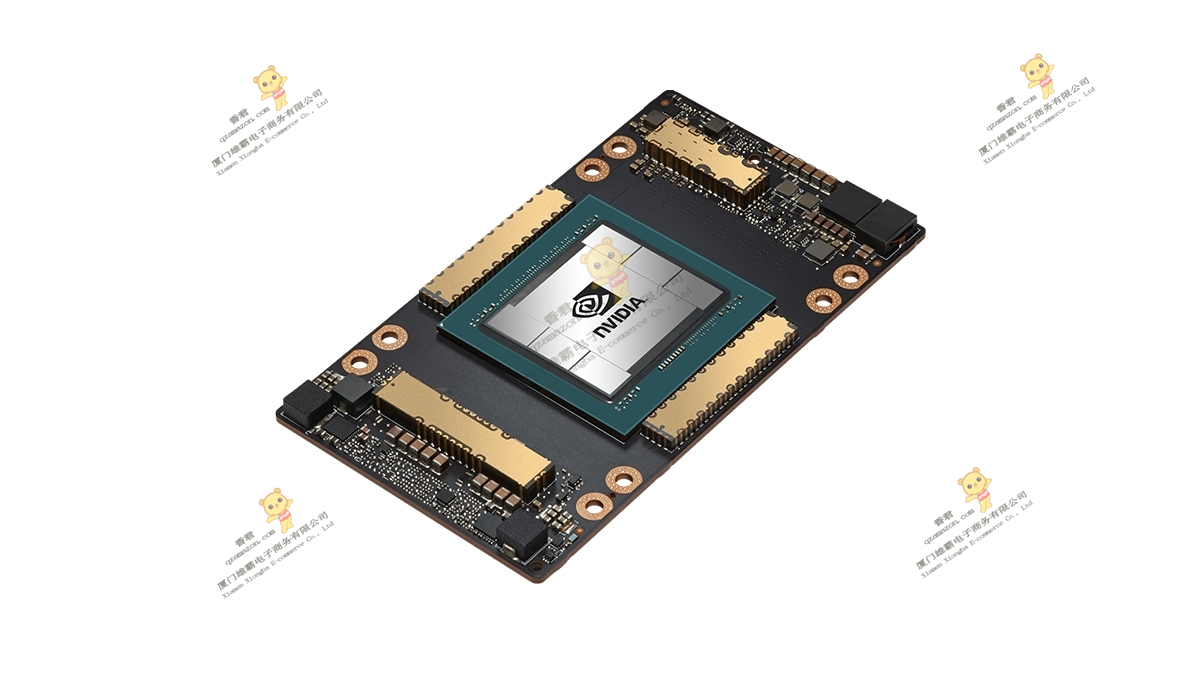

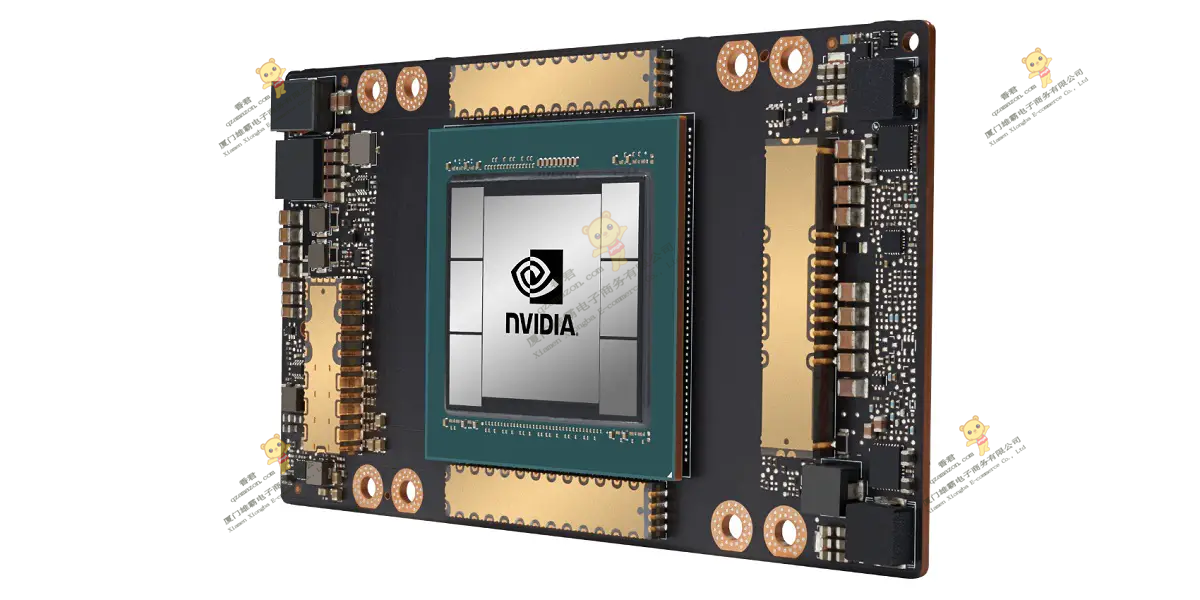

H800 GPU硬件架构

NVIDIA H800 GPU 由多个 GPU 处理集群 (GPC)、纹理处理集群 (TPC)、流式多处理器 (SM) 和 HBM2 内存控制器组成。

H800 GPU 的完整实现包括以下单元:

8 个 GPC、8 个 TPC/GPC、2 个 SM/TPC、16 个 SM/GPC、每个完整 GPU 128 个 SM

64 个 FP32 CUDA 核心/SM,每个完整 GPU 8192 个 FP32 CUDA 核心

4 个第三代 Tensor Cores/SM,每个完整 GPU 512 个第三代 Tensor Cores

6 个 HBM2 堆栈、12 512 位内存控制器

GA100 GPU 的A100 Tensor Core GPU 实现包括以下单元:

7 个 GPC、7 或 8 个 TPC/GPC、2 个 SM/TPC、多 16 个 SM/GPC、108 个 SM

64 个 FP32 CUDA 核心/SM,每个 GPU 6912 个 FP32 CUDA 核心

4 个第三代 Tensor Cores/SM,每个 GPU 432 个第三代 Tensor Cores

5 个 HBM2 堆栈、10 个 512 位内存控制器

这里简要强调了 SM 的关键功能,并在本文后面详细描述:

第三代张量核心:

所有数据类型的加速,包括 FP16、BF16、TF32、FP64、INT8、INT4 和二进制。

新的 Tensor Core 稀疏性功能利用了深度学习网络中的细粒度结构化稀疏性,使标准 Tensor Core 操作的性能提高了一倍。

A100 中的 TF32 Tensor Core 运算提供了一种简单的方法来加速 DL 框架和 HPC 中的 FP32 输入/输出数据,其运行速度比 V100 FP32 FMA 运算快 10 倍,或者在稀疏性情况下快 20 倍。

FP16/FP32 混合精度 Tensor Core 运算为深度学习提供了。。处理能力,运行速度比 V100 Tensor Core 运算快 2.5 倍,稀疏性增加到 5 倍。

BF16/FP32 混合精度 Tensor Core 运算的运行速度与 FP16/FP32 混合精度相同。

FP64 Tensor Core 运算为 HPC 提供了的双精度处理能力,运行速度比 V100 FP64 DFMA 运算快 2.5 倍。

具有稀疏性的 INT8 Tensor Core 运算为深度学习推理提供了。。的处理能力,运行速度比 V100 INT8 运算快 20 倍。

192 KB 组合共享内存和 L1 数据缓存,比 V100 SM 大 1.5 倍。

新的异步复制指令将数据直接从全局内存加载到共享内存中,可选择绕过 L1 缓存,并消除中间寄存器文件 (RF) 使用的需要。

新的基于共享内存的屏障单元(异步 屏障)与新的异步复制指令一起使用。

L2 缓存管理和驻留控制的新指令。

CUDA 合作组支持的新扭曲级别缩减指令。

许多可编程性改进可降低软件复杂性。

8 个 GPC、8 个 TPC/GPC、2 个 SM/TPC、16 个 SM/GPC、每个完整 GPU 128 个 SM

8 个 GPC、8 个 TPC/GPC、2 个 SM/TPC、16 个 SM/GPC、每个完整 GPU 128 个 SM